Diep web

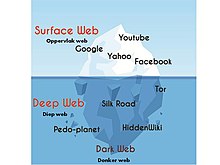

Die diep web[1], onsigbare web[2], of verborge web[3] is dele van die Wêreldwye Web waarvan die inhoud nie deur gewone websoekenjins geïndekseer word nie. Die teenoorgestelde term van die diep web is die oppervlakweb, wat toeganklik is vir enigiemand wat die internet gebruik.[4] Rekenaarwetenskaplike Michael K. Bergman word gekrediteer vir die skep van die term diep web in 2001 as ’n soekindeksterm.

Die inhoud van die diep web is weggesteek agter HTTP-vorms[5][6], en sluit baie algemene gebruike soos webpos, internetbankdienste en dienste in waar gebruikers voor moet betaal, en wat deur ’n betaalmuur beskerm word, soos onder meer video-op-aanvraag, sommige aanlyntydskrifte en -koerante.

Die inhoud van die diep web kan deur ’n direkte URL of IP-adres gevind word en toegang tot die webwerf kan wagwoorde vereis.

Terminologie

[wysig | wysig bron]Die eerste samesmelting van die terme “diep web” en “donker web” het in 2009 ontstaan toe die diep web soekterminologie saam met onwettige aktiwiteite op die Freenet darknet bespreek is.[7]

Sedert die media verslag gelewer het van die Silk Road, het baie[8][9] mense en media begin om die diep web as sinoniem van die donker web of donkernet te gebruik. Sodanige vergelyking behoort as onakkuraat verwerp te word[10], en is gevolglik ’n deurlopende bron van verwarring.[11] Die verslaggewers Kim Zetter[12] en Andy Greenberg[13] beveel aan dat die terme in verskillende kontekste gebruik word. Terwyl die diep web verwys na enige webwerf wat nie deur ’n tradisionele soekenjin verkry kan word nie, is die donker web ’n gedeelte van die diep web wat doelbewus verborge is en ontoeganklik is vir standaardwebblaaiers en ander soekmetodes.[14][15][16][17][18]

Nie-geïndekseerde inhoud

[wysig | wysig bron]In ’n berig oor die diep web wat inThe Journal of Electronic Publishing gepubliseer is, het Bergman genoem dat Jill Ellsworth die term Invisible Web (onsigbare web) in 1994 gebruik het om te verwys na webwerwe wat nie by enige soekenjin geregistreer was nie.[19] Bergman het ’n artikel deur Frank Garcia van Januarie 1996 aangehaal[20]:

“Dit sal ’n webwerf wees wat moontlik redelik ontwerp is, maar hulle was nie gepla om dit met enige soekenjins te registreer nie. So, niemand kan hulle vind nie! Jy is versteek. Ek noem dit die onsigbare web.”

Nog ’n vroeë gebruik van die term “onsigbare web”, was deur Bruce Mount en Matthew B. Koll van Personal Library Software, in ’n beskrywing van die # 1 Deep Web-hulpmiddel wat in ’n persverklaring van Desember 1996 gevind is.[21]

Die eerste gebruik van die spesifieke term diep web, wat nou algemeen aanvaar word, het in die bogenoemde 2001 Bergman-studie voorgekom.[19]

Indekseringsmetodes

[wysig | wysig bron]Metodes wat verhoed dat webbladsye deur tradisionele soekenjins geïndekseer word, kan as een of meer van die volgende gekategoriseer word:

- Kontekstuele web: bladsye met inhoud wat wissel vir verskillende toegangskontekste (bv. reekse van kliënt-IP-adresse of vorige navigasiereekse).

- Dinamiese inhoud: dinamiese bladsye, wat teruggestuur word in reaksie op ’n ingeslote navraag of slegs deur ’n vorm verkry word, veral as toevoerelemente van oop domein (soos teksvelde) gebruik word; sulke velde is moeilik om te navigeer sonder domeinkennis.

- Beperkte toegangsinhoud: webwerwe wat die toegang tot hul bladsye op ’n tegniese manier beperk (bv. die gebruik van die Robot-uitsluitingstandaard of CAPTCHAs, of geen-winkel-riglyn, wat soekenjins verbied om hulle te blaai en kopieë in die kasgeheue te maak.[22]

- Nie-HTML/teksinhoud: teksinhoud geïnkripteer in multimedialêers (beeld of video) of spesifieke lêerformate wat nie deur soekenjins hanteer word nie.

- Privaat web: webwerwe wat registrasie en inskrywing benodig (wagwoordbeskermde hulpbronne).

- Skrip inhoud: bladsye wat slegs toeganklik is deur middel van skakels wat deur JavaScript geskep word, sowel as inhoud wat dinamies afgelaai is van webbedieners via Flash of AJAX-oplossings.

- Programmatuur: sekere inhoud is doelbewus weggesteek van die gewone internet, slegs toeganklik met spesiale sagteware, soos TOR (Uie-roeteerder-enkripteerder), I2P, of ander donkernetprogrammatuur. TOR verleen byvoorbeeld aan gebruikers anonieme toegang tot webwerwe met die .onion-bedieneradres deur hul IP-adres te versteek.

- Onverwante inhoud: bladsye wat nie deur ander bladsye gekoppel is nie, kan voorkom dat webkruipprogramme toegang tot die inhoud verkry. Hierdie inhoud word na verwys as bladsye sonder terugskakels (ook bekend as binneskakels). Ook soek soekenjins nie altyd alle terugskakels vanaf gesoekte webblaaie nie.

- Web argiewe: Web argiefdienste soos die Wayback-masjien stel gebruikers in staat om argiefweergawes van webblaaie oor tyd te sien, insluitende webwerwe wat ontoeganklik geword het en nie deur soekenjins soos Google geïndekseer word nie.[9]

Soorte inhoud

[wysig | wysig bron]Alhoewel dit nie altyd moontlik is om ’n spesifieke webbediener se inhoud direk te ontdek nie, sodat dit geïndekseer kan word, kan indirek toegang tot so ’n webwerf wel verkry word (weens rekenaarkwesbaarhede).

Om inhoud op die web te ontdek, gebruik soekenjins webkruipers wat hiperskakels volg deur bekende protokol virtuele poortnommers. Hierdie tegniek is ideaal vir die ontdekking van inhoud op die oppervlakweb, maar is dikwels ondoeltreffend om diep webinhoud te vind. Hierdie kruipers probeer byvoorbeeld nie dinamiese bladsye te vind wat die gevolg is van databasisnavrae as gevolg van die onbepaalde aantal navrae wat moontlik is nie.[23] Daar is opgemerk dat dit gedeeltelik oorkom kan word deur skakels te verskaf om resultate te vra, maar dit kan die gewildheid van 'n webwerf van die diep web onopopsetlik vergroot.

DeepPeep, Intute, Deep Web Technologies, Scirus en Ahmia.fi is ’n paar soekenjins wat toegang tot die diep web het. Intute het sy finansiering verloor en is sedert Julie 2011 ’n tydelike statiese argief.[24] Scirus het aan die einde van Januarie 2013 opgehou funksioneer.[25]

Navorsers het ondersoek ingestel na hoe die diep web outomaties ondersoek kan word, insluitend inhoud wat slegs deur spesiale sagteware soos Tor verkry kan word. In 2001 het Sriram Raghavan en Hector Garcia-Molina van Stanford-universiteit se Departement Rekenaarwetenskap[26][27] ’n argitektoniese model voorgestel vir ’n versteekte webkruiper wat sleutelterme wat deur gebruikers verskaf is of versamel is van die navraagkoppelvlakke om navraag te doen ’n webform en die diep webinhoud te ondersoek.[28] Verskeie vormnavraagtale (soos byvoorbeeld, DEQUEL[29]) is voorgestel waar, buiten die uitreiki van ’n navraag, ook die uitruil van gestruktureerde data uit die resultaatbladsye toegelaat word. Nog ’n poging is DeepPeep, ’n projek van die Universiteit van Utah wat deur die National Science Foundation geborg is, wat verborge webbronne (webvorms) in verskillende domeine versamel het gebaseer op ’n gefokusde kruiper.[30][31]

Kommersiële soekenjins het begin met die ondersoek van alternatiewe metodes om die diep web te ondersoek. Die sitemap-protokol (wat in 2005 deur Google ontwikkel) en OAI-PMH, is meganismes waarmee soekenjins en ander belanghebbende webwerwe op sekere webbedieners kan ontdek. Beide meganismes laat webbedieners toe om die URL’s wat op hulle toeganklik is, te adverteer en sodoende outomatiese ontdekking van hulpbronne wat nie direk aan die oppervlakweb gekoppel is nie, toe te laat. Google se webwerwe vir diep webwerwe bereken voorleggings vir elke HTML-vorm en voeg die gevolglike HTML-bladsye by die Google-soekenjin-indeks. Die opgedateerde resultate is verantwoordelik vir ’n duisend navrae per sekonde op die diep webinhoud.[32] In hierdie stelsel word die voorberekening van voorleggings gedoen met behulp van drie algoritmes:

- Invoerwaardes kies vir teks soek insette wat sleutelwoorde aanvaar,

- identifiseer insette wat slegs waardes van ’n spesifieke tipe (bv. Datum) en

- kies ’n klein aantal invoerkombinasies wat URL’s genereer wat geskik is vir insluiting in die web soek indeks.

Om gebruikers van Tor-verborge-dienste in hul toegang en soektog na ’n verborge .onion-agtervoegsel te fasiliteer, het Aaron Swartz in 2008 Tor2web ontwerp - ’n proxy-aansoek wat toegang verleen deur middel van algemene webblaaiers.[33] Deur hierdie toepassing te gebruik, verskyn diep webskakels as ’n ewekansige string van letters, gevolg deur die .onion TLD.

Verwysings

[wysig | wysig bron]- ↑ Hamilton, Nigel. "The Mechanics of a Deep Net Metasearch Engine". CiteSeerX 10.1.1.90.5847.

{{cite journal}}: Cite journal requires|journal=(hulp) - ↑ Devine, Jane; Egger-Sider, Francine (Julie 2004). "Beyond google: the invisible web in the academic library". The Journal of Academic Librarianship. 30 (4): 265–269. doi:10.1016/j.acalib.2004.04.010. Besoek op 6 Februarie 2014.

- ↑ Raghavan, Sriram; Garcia-Molina, Hector (11–14 September 2001). "Crawling the Hidden Web". 27th International Conference on Very Large Data Bases.

- ↑ "Surface Web" (in Engels). Computer Hope. Geargiveer vanaf die oorspronklike op 5 Mei 2020. Besoek op 20 Junie 2018.

- ↑ Madhavan, J., Ko, D., Kot, Ł., Ganapathy, V., Rasmussen, A., & Halevy, A. (2008). Google’s deep web crawl. Proceedings of the VLDB Endowment, 1(2), 1241–52.

- ↑ Shedden, Sam (8 Junie 2014). "How Do You Want Me to Do It? Does It Have to Look like an Accident? – an Assassin Selling a Hit on the Net; Revealed Inside the Deep Web". Sunday Mail. Geargiveer vanaf die oorspronklike op 1 Maart 2020. Besoek op 5 Mei 2017 – via Questia.

- ↑ Beckett, Andy (26 November 2009). "The dark side of the internet" (in Engels). Geargiveer vanaf die oorspronklike op 30 Desember 2019. Besoek op 9 Augustus 2015.

- ↑ Daily Mail Reporter (11 Oktober 2013). "The disturbing world of the Deep Web, where contract killers and drug dealers ply their trade on the internet" (in Engels). Geargiveer vanaf die oorspronklike op 30 April 2020. Besoek op 25 Mei 2015.

- ↑ 9,0 9,1 "NASA is indexing the 'Deep Web' to show mankind what Google won't" (in Engels). Fusion. Geargiveer vanaf die oorspronklike op 23 Februarie 2017.

- ↑ "Clearing Up Confusion – Deep Web vs. Dark Web" (in Engels). BrightPlanet. 27 Maart 2014. Geargiveer vanaf die oorspronklike op 29 April 2019.

- ↑ Solomon, Jane (6 Mei 2015). "The Deep Web vs. The Dark Web" (in Engels). Geargiveer vanaf die oorspronklike op 14 Augustus 2017. Besoek op 26 Mei 2015.

- ↑ NPR Staff (25 Mei 2014). "Going Dark: The Internet Behind The Internet" (in Engels). Geargiveer vanaf die oorspronklike op 7 Mei 2020. Besoek op 29 Mei 2015.

- ↑ Greenberg, Andy (19 November, 2014). "Hacker Lexicon: What Is the Dark Web?" (in Engels). Geargiveer vanaf die oorspronklike op 6 Mei 2020. Besoek op 6 Junie 2015.

{{cite news}}: Gaan datum na in:|date=(hulp) - ↑ "The Impact of the Dark Web on Internet Governance and Cyber Security" (PDF). Besoek op 15 Januarie, 2017.

{{cite web}}: Gaan datum na in:|accessdate=(hulp) - ↑ Lam, Kwok-Yan; Chi, Chi-Hung; Qing, Sihan (23 November 2016). Information and Communications Security: 18th International Conference, ICICS 2016, Singapore, Singapore, 29 November – 2 Desember 2016, Proceedings (in Engels). Springer. ISBN 9783319500119. Besoek op 15 Januarie 2017.

- ↑ "The Deep Web vs. The Dark Web | Dictionary.com Blog". Dictionary Blog. 6 Mei 2015. Besoek op 15 Januarie 2017.

- ↑ Akhgar, Babak; Bayerl, P. Saskia; Sampson, Fraser (1 Januarie 2017). Open Source Intelligence Investigation: From Strategy to Implementation (in Engels). Springer. ISBN 9783319476711. Besoek op 15 Januarie 2017.

- ↑ "What is the dark web and who uses it?". The Globe and Mail (in Engels). Geargiveer vanaf die oorspronklike op 21 Julie 2017. Besoek op 15 Januarie 2017.

- ↑ 19,0 19,1 Bergman, Michael K (Augustus 2001). "The Deep Web: Surfacing Hidden Value". The Journal of Electronic Publishing. 7 (1). doi:10.3998/3336451.0007.104.

- ↑ Garcia, Frank (Januarie 1996). "Business and Marketing on the Internet". Masthead. 15 (1). Geargiveer vanaf die oorspronklike op 5 Desember 1996. Besoek op 24 Februarie 2009.

- ↑ @1 started with 5.7 terabytes of content, estimated to be 30 times the size of the nascent World Wide Web; PLS was acquired by AOL in 1998 and @1 was abandoned. Personal Library Software (Desember 1996). "PLS introduces AT1, the first ‘second generation’ Internet search service". Persberig. Archived from the original on 21 Oktober 1997. https://web.archive.org/web/19971021232057/http://www.pls.com/news/pr961212_at1.html. Besoek op 24 Februarie 2009.

- ↑ "Hypertext Transfer Protocol (HTTP/1.1): Caching" (in Engels). Internet Engineering Task Force. 2014. Geargiveer vanaf die oorspronklike op 28 April 2020. Besoek op 30 Julie 2014.

- ↑ Wright, Alex (22 Februarie 2009). "Exploring a 'Deep Web' That Google Can't Grasp". The New York Times. Besoek op 23 Februarie 2009.

- ↑ "Intute FAQ" (in Engels). Geargiveer vanaf die oorspronklike op 5 Junie 2014. Besoek op 13 Oktober 2012.

- ↑ "Elsevier to Retire Popular Science Search Engine". library.bldrdoc.gov (in Engels). Desember 2013. Geargiveer vanaf die oorspronklike op 29 Desember 2016. Besoek op 22 Junie 2015.

by end of January 2014, Elsevier will be discontinuing Scirus, its free science search engine. Scirus has been a wide-ranging research tool, with over 575 million items indexed for searching, including webpages, pre-print articles, patents, and repositories.

- ↑ Sriram Raghavan; Garcia-Molina, Hector (2000). "Crawling the Hidden Web" (PDF). Stanford Digital Libraries Technical Report. Geargiveer vanaf die oorspronklike (PDF) op 8 Mei 2018. Besoek op 27 Desember 2008.

{{cite journal}}: Cite journal requires|journal=(hulp) - ↑ Raghavan, Sriram (2001). "Crawling the Hidden Web" (PDF). Proceedings of the 27th International Conference on Very Large Data Bases (VLDB) pages=129–38.

- ↑ Alexandros, Ntoulas; Zerfos, Petros; Cho, Junghoo (2005). "Downloading Hidden Web Content" (PDF). UCLA Computer Science. Besoek op 24 Februarie 2009.

{{cite journal}}: Cite journal requires|journal=(hulp) - ↑ Shestakov, Denis; Bhowmick, Sourav S.; Lim, Ee-Peng (2005). "DEQUE: Querying the Deep Web" (PDF). Data & Knowledge Engineering. 52 (3): 273–311.

- ↑ Barbosa, Luciano; Freire, Juliana (2007). "An Adaptive Crawler for Locating Hidden-Web Entry Points" (PDF). WWW Conference 2007. Geargiveer vanaf die oorspronklike (PDF) op 5 Junie 2011. Besoek op 20 Maart 2009.

{{cite journal}}: Cite journal requires|journal=(hulp) - ↑ Barbosa, Luciano; Freire, Juliana (2005). "Searching for Hidden-Web Databases" (PDF). WebDB 2005. Geargiveer vanaf die oorspronklike (PDF) op 5 Junie 2011. Besoek op 20 Maart 2009.

{{cite journal}}: Cite journal requires|journal=(hulp) - ↑ Madhavan, Jayant; Ko, David; Kot, Łucja; Ganapathy, Vignesh; Rasmussen, Alex; Halevy, Alon (2008). "Google's Deep-Web Crawl" (PDF). VLDB Endowment, ACM. Geargiveer vanaf die oorspronklike (PDF) op 16 September 2012. Besoek op 17 April 2009.

{{cite journal}}: Cite journal requires|journal=(hulp) - ↑ Aaron, Swartz. "In Defense of Anonymity" (in Engels). Geargiveer vanaf die oorspronklike op 20 Augustus 2019. Besoek op 4 Februarie 2014.

| Hierdie artikel is in sy geheel of gedeeltelik vanuit die Engelse Wikipedia vertaal. |